вопрос: получается если у товара есть URL 1- то чтобы его направлять через 301 на URL 2, надо все равно зайти в товар, заменить там URL на URL 2, затем в настройках сделать

редирект с URL 1 на URL 2, много ручной работы…

вот бы как-то автоматизировать, например у меня куча товаров где в URL стоит product-kakoy-to-nomer…

URL то вроде массово можно переделать, а вот дальше ходить и каждый URL вписывать 301 это печально…

p.s. хорошо бы вместо видео инструкций, иметь текстовую инструкцию, видео сильно неудобно смотреть, да и восприятие порой страдает ( часть людей явно текст лучше воспринимает, чем видео), на текстовую зашел, ага скриншоты со стрелочками, текст, это всё куда понятней и быстрей, да и яндекс с гуглом порадуются, пригонят людей)))

Нет, если у товара поменять url, то редирект добавится автоматом.

Пока так(

Можно ли настроить автоматические редиректы для товаров, которых нет в наличии? на страницу главной подкатегории этих товара, а если вновь товар появляется в продаже, то редирект отключался? Сейчас для таких товаров отдается страница 404, что плохо для SEO.

Как грамотно проставлять 301 редирект чтобы не попасть под фильтры Яндекс

Делать это нужно с головой и в ручном режиме. К примеру, если вы удалили карточку с каким-либо товаром, то 301 редирект не нужно ставить на главную, а надо привести пользователя в рубрику продажи похожих товаров, либо услуг, смотря что продаёт ваш сайт. Тогда посетитель не покинет ваш ресурс, как в первом случае, а выберет другой товар или услугу и станет вашим покупателем. Так это и работает!!!

В большинстве случаев, [ленивые SEO оптимизаторы] так не заморачиваются, особенно если речь идет о крупных интернет магазинах с сотнями тысяч товаров. Они прописывают 301 редирект в автоматическом режиме и это разгильдяйство безжалостно топит SEO продвижение интернет магазина на «морское дно интернета».

И вопрос по SEO:

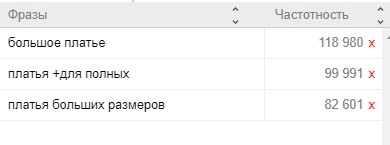

Есть три SEO страницы фильтров которые ведут на одну и ту же выборку товаров.

Стоит ли, с точки зрения SEO, сделать редиректы со страниц с меньшей частотностью на страницу с частотность максимальной?

Платон Щукин. Дубли: как их избежать. Вопросы и ответы.

5 декабря 2017, 14:08

В советах интернет-магазинам я уже затрагивал страницы товаров с похожим или идентичным контентом. Сегодня расскажу о том, как избежать признания страниц дублирующими, и отвечу на популярные вопросы по этой теме.

Что называем дублями?

Страницы, текстовое содержимое которых полностью или практически совпадает.

Популярные примеры это страницы с GET-параметрами и метками (UTM и др.) в url, а также страницы в разных разделах сайта с отличающимся только url. Наличие таковых не приносит пользы и может негативно сказаться на разных этапах взаимодействия с поисковой системой:

- До момента определения страниц дублями они могут конкурировать между собой в результатах поиска по запросам и пользователь после перехода на сайт может оказаться не на целевой для него странице.

- Когда индексирующий робот определит дубли, в поиске останется только одна страница-дубль, которая будет выбрана автоматически. А так как робот может пересматривать свой выбор, то страница в поиске может меняться.

- На обход дублей роботу требуется время, из-за чего обход нужных страниц сайта может занимать больше времени.

Чтобы избавиться от дублей и последствий их появления, мы рекомендуем настраивать у них атрибут rel=“canonical”, указывая основной адрес, либо использовать редирект 301 на нужные страницы - это укажет роботу на то, какая из страниц должна быть в поиске.

Случается, что робот признаёт дублями разные, казалось бы по внешнему виду, страницы. А присутствие в поиске каждой могло быть полезно сайту и пользователю, который осуществляет поиск. Единственно правильное решение это сделать их значительно отличающимися:

- добавить разное текстовое содержимое;

- добавить UGC в виде возможности пользователям оставлять комментарии, рецензии и т.п.;

- не лучший, но действующий метод - использование тега noindex: “шаблон” сайта содержит на страницах большое количество текста, который совпадает на всех страницах, что может частично повлиять на признание страниц дублями. В такой ситуации возможно использовать тег noindex, запретив к индексированию совпадающий текст: меню навигации, “подвал” сайта и т.п., то есть всё то, что робот видит в качестве идентичного текста.

Рубрика Вопрос/Ответ

В. У страниц почти одинаковый адрес, не посчитает ли их робот дублирующими?

О. Нет, сравнивается непосредственно содержимое самих страниц и адрес не играет роли.

В. У меня фото разное на страницах, а текст одинаковый, будут дубли?

О. Да, такие страницы будут признаны дублирующими. Чтобы страницы индексировались отдельно друг от друга, необходимы отличия в текстовом содержимом.

В. Совершенно разные по содержимому и тексту страницы признаются дублями одной страницы и исключаются из поиска, почему?

О. Такая ситуация, как правило, связана с тем, что страницы в какой-то момент отдавали сообщение об ошибке. Проверить это можно при помощи оператора [url:] в результатах поиска. Найдите с его помощью страницу-дубль, включенную в поиск: в описании страницы будет отображаться то сообщение, которое получал наш робот, когда посещал страницы. Проверьте сохраненную копию страницы: в ней тоже мог сохраниться контент, получаемый роботом. Используя инструмент “Проверка ответа сервера” посмотрите, какое содержимое страницы отдают сейчас. Если страницы отдают разное содержимое, то они смогут вернуться в поиск после их повторного индексирования. Ускорить этот процесс поможет инструмент переобхода в Яндекс.Вебмастере.

Чтобы избежать исключения страниц из поиска в случае кратковременной недоступности сайта, мы рекомендуем настраивать со страниц HTTP-код ответа 503.

В. Со страниц-дублей установлен редирект на нужные страницы, но в поиске все равно участвуют неправильные страницы.

О. Убедитесь, что на страницах установлен постоянный редирект 301. В случае временного редиректа 302 или использования мета-тега refresh в поиске может участвовать страница по наиболее короткому адресу. Если установлен постоянный редирект, возможно, что робот еще не успел повторно проиндексировать страницу: с помощью инструмента “Проверка статуса URL” Вы можете проверить, какая версия страницы участвует в поиске и ее статус. Ускорить переобход страниц с редиректом также поможет “Переобход страниц” - в течение одной-двух недель они выпадут из поиска.

В. Можно ли использовать директиву Disallow в robots.txt для запрета индексирования дублей?

О. Да, такой запрет можно использовать, однако при использовании директивы Disallow передать какие-либо показатели запрещенных страниц не получится, поэтому мы рекомендуем использовать атрибут тега rel=“canonical”, либо редирект. Для страниц с GET-параметрами можно использовать директиву Clean-param.

В. На страницы товаров больше нечего добавить: они, к примеру, отличаются только фото, но цена и описание одинаковые.

О. Возможно, стоит пересмотреть структуру сайта: такие страницы, кажется, не смогут находиться по релевантным запросам, поэтому часто их стоит объединить в одну страницу и использовать её в качестве посадочной страницы по группе запросов.

Наверное, нет, так как страницы с редиректом, спустая какое-то время, просто выпадут из поиска.

По умолчанию нет. Да и не встречал такого поведения на других сайтах.

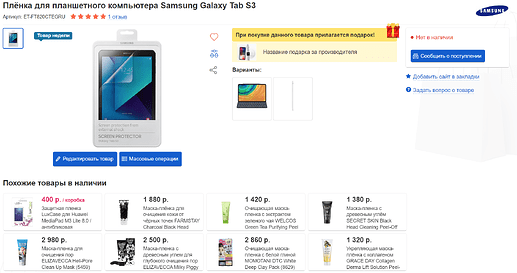

Не так, сейчас если товара нет в наличии он так же отдает 200.

карточка товара становится уже и под фото показаны товары в наличии.

Думаю стоит для каждой добавить свой сео текст в описание, 301 делать не нужно.

Это если количество товара 0, а если статус Отключен, то отдается 404 редирект.

Так как с годами неизбежно количестов товаров не в наличии становится больше тех, что в наличии, иногда в разы, то поневоле приходится ставить статус Отключен, хотя по ним все еще возможен какой-то трафик.

Спасибо, наверное, так правильно будет.

Да, это боль всех магазинов

Чур, я первый в очереди на доработку ![]()

Боль Антоном устранена - 11 лет мучился )))

Большущее спасибо за seo апгрейд!